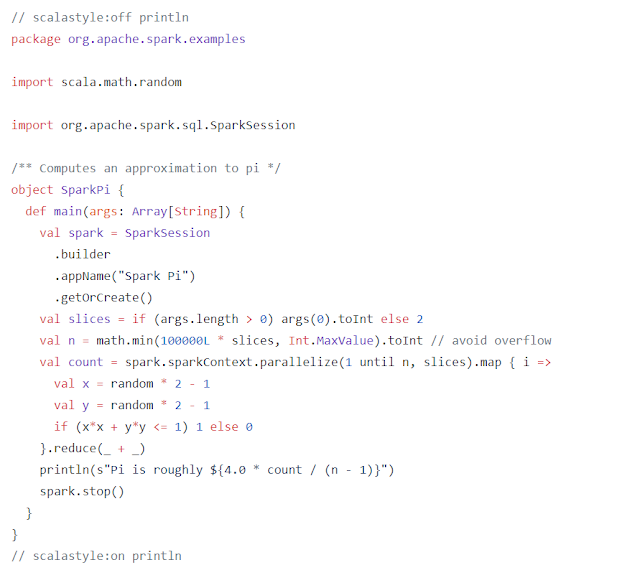

[SPARK] RDD, Action 和 Transformation (2)

在Spark中, 資料的基本架構為 RDD (Resilient Distributed Dataset), RDDs 可以使用 Hadoop InputFormats (例如 HDFS 文件) 創建, 也可以從其他的 RDDs 轉換. 我們可以簡單的從一個文字檔建立 RDD, 例如: scala> val textFile = sc.textFile("README.md") 基本上, 就是從文字檔中建立一個 RDD 物件, 此時, 該 RDD 物件已經轉換成 string array 的格式, 可以透過: scala> textFile.collect() 查看, RDD 仍保有HDFS的特性, 也就是 key-value 的格式, 在 textFile 這個 RDD 中, key 就是第幾行, value 則是每行的數值, 對於所有的 RDD, 我們都有兩種操作: action 和 transformation, RDD 的 actions 從 RDD 中返回值, transformations 可以轉換成一個新 RDD 並返回它的引用. 如下圖表示: https://stackoverflow.com/questions/39311616/transformation-process-in-apache-spark